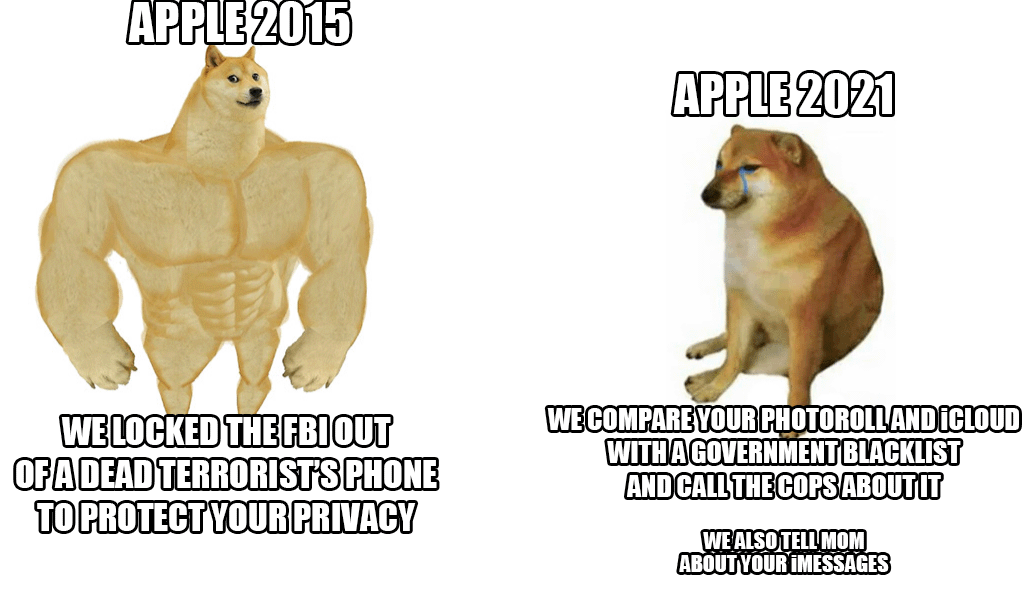

ໃນທ້າຍອາທິດທີ່ຜ່ານມາ, Apple ໄດ້ເປີດເຜີຍລະບົບຕ້ານການລ່ວງລະເມີດເດັກ ໃໝ່ ທີ່ຈະສະແກນຮູບພາບ iCloud ຂອງທຸກໆຄົນ. ເຖິງແມ່ນວ່າຄວາມຄິດຈະດີຢູ່ glance ທໍາອິດ, ຍ້ອນວ່າເດັກນ້ອຍກໍ່ຕ້ອງໄດ້ຮັບການປົກປ້ອງຈາກການກະທໍານີ້, ຍັກໃຫຍ່ Cupertino ໄດ້ຖືກວິພາກວິຈານຢ່າງໃດກໍ່ຕາມໂດຍການລະເບີດ - ບໍ່ພຽງແຕ່ຈາກຜູ້ໃຊ້ແລະຜູ້ຊ່ຽວຊານດ້ານຄວາມປອດໄພ, ແຕ່ຍັງມາຈາກລະດັບຂອງພະນັກງານເອງ.

ອີງຕາມຂໍ້ມູນຫຼ້າສຸດຈາກອົງການທີ່ເຄົາລົບ Reuters ພະນັກງານຈໍານວນຫນຶ່ງສະແດງຄວາມກັງວົນກ່ຽວກັບລະບົບນີ້ໃນການສື່ສານພາຍໃນ Slack. ຖືກກ່າວຫາວ່າ, ພວກເຂົາຄວນຈະຢ້ານກົວຕໍ່ການລ່ວງລະເມີດທີ່ເປັນໄປໄດ້ໂດຍອໍານາດການປົກແລະລັດຖະບານ, ຜູ້ທີ່ສາມາດລ່ວງລະເມີດຄວາມເປັນໄປໄດ້ເຫຼົ່ານີ້, ຕົວຢ່າງ, ເພື່ອ censor ປະຊາຊົນຫຼືກຸ່ມທີ່ເລືອກ. ການເປີດເຜີຍຂອງລະບົບໄດ້ເຮັດໃຫ້ເກີດການໂຕ້ວາທີທີ່ເຂັ້ມແຂງ, ເຊິ່ງມີຫຼາຍກວ່າ 800 ຂໍ້ຄວາມສ່ວນບຸກຄົນພາຍໃນ Slack ທີ່ໄດ້ກ່າວມາຂ້າງເທິງ. ໃນສັ້ນ, ພະນັກງານມີຄວາມກັງວົນ. ເຖິງແມ່ນວ່າຜູ້ຊ່ຽວຊານດ້ານຄວາມປອດໄພໃນເມື່ອກ່ອນໄດ້ດຶງດູດຄວາມສົນໃຈກັບຄວາມຈິງທີ່ວ່າໃນມືທີ່ບໍ່ຖືກຕ້ອງມັນຈະເປັນອາວຸດທີ່ເປັນອັນຕະລາຍແທ້ໆທີ່ໃຊ້ໃນການສະກັດກັ້ນນັກເຄື່ອນໄຫວ, ການ censorship ທີ່ໄດ້ກ່າວມາຂອງພວກເຂົາແລະສິ່ງອື່ນໆ.

ຂ່າວດີ (ເຖິງຕອນນັ້ນ) ແມ່ນວ່າຄວາມແປກໃຫມ່ຈະເລີ່ມຕົ້ນໃນສະຫະລັດເທົ່ານັ້ນ. ໃນເວລານີ້, ມັນຍັງບໍ່ຊັດເຈນວ່າລະບົບຈະຖືກນໍາໃຊ້ພາຍໃນປະເທດຂອງສະຫະພາບເອີຣົບ. ຢ່າງໃດກໍຕາມ, ເຖິງວ່າຈະມີການວິພາກວິຈານທັງຫມົດ, Apple ຢືນຢູ່ດ້ວຍຕົນເອງແລະປ້ອງກັນລະບົບ. ລາວໂຕ້ແຍ້ງຂ້າງເທິງວ່າການກວດສອບທັງຫມົດເກີດຂຶ້ນພາຍໃນອຸປະກອນແລະເມື່ອມີຄໍາທີ່ກົງກັນ, ຫຼັງຈາກນັ້ນພຽງແຕ່ໃນຂະນະນັ້ນກໍລະນີຖືກກວດສອບອີກເທື່ອຫນຶ່ງໂດຍພະນັກງານ Apple. ພຽງແຕ່ຕາມການຕັດສິນໃຈຂອງລາວເທົ່ານັ້ນທີ່ຈະມອບໃຫ້ເຈົ້າຫນ້າທີ່ທີ່ກ່ຽວຂ້ອງ.

ມັນອາດຈະເປັນ ສົນໃຈເຈົ້າ

ຂ້າພະເຈົ້າບໍ່ຢາກປ່ຽນຈາກ iCloud ເປັນບາງສິ່ງບາງຢ່າງທີ່ປອດໄພແລະເປັນເອກະຊົນແທ້ຈິງ, ແຕ່ຖ້າຫາກວ່າ Apple ຢືນຢັນ, ຂ້າພະເຈົ້າຈະຢຸດເຊົາການຈ່າຍໃຫ້ເຂົາເຈົ້າຢ່າງໃດກໍຕາມ.

ມັນຈະມີການເຄື່ອນໄຫວ (ສໍາລັບໃນປັດຈຸບັນ) ພຽງແຕ່ໃນສະຫະລັດ

ມັນບໍ່ສໍາຄັນແທ້ໆທີ່ມັນຈະນໍາໃຊ້ນິຕິກໍາ. ເທັກໂນໂລຍີນັ້ນຈະອອກມາແລ້ວ ແລະຖືກນຳໃຊ້. ນັ້ນແມ່ນຄວາມສ່ຽງທີ່ໃຫຍ່ທີ່ສຸດ.